Qu'est-ce que le robots.txt ?

Robots.txt est un fichier qui sur lequel sont écrits des restrictions sur l’exploration de vos pages aux moteurs de recherche.

C’est un fichier dédiée aux robots d’explorations, et donc, au moteur de recherche tel que Google, Bing..

- Il permet d’indiquer aux robots d’exploration de ne pas crawlé certaines pages de votre site internet

- Il permet également de spécifier le chemin vers un sitemap

Google vous recommande fortement d’intégrer un robots.txt à votre site internet pour de bonnes raisons

Pourquoi modifier le fichier Robots.txt ?

En permettant de donner des consignes et des règles aux différents robots des moteurs de recherche, le fichier robots.txt permet d’éviter d’indexer certaines pages sur internet. Particulièrement intéressant pour vos pages mentions légales, ou bien des pages qui ne sont pas censées être retrouvées sur le web.

Cela permet d’économiser des ressources à Google de ne pas explorer votre page. Il se concentrera vers vos pages qui performent le plus.

Certaines pages de votre site sont visibles sur internet, et vous ne voudriez pas qu’elles le soient ? Plus de la majorité des sites web présentent des pages qui ne sont pas forcément vouées à être référencer sur le web. En effet, il se pourrait bien que votre site contienne des pages qui ne sont pas censées être trouvées par un moteur de recherche, mais qui peut tout de même ajouter une plus-value à l’expérience utilisateur sur votre site.

Voici 3 raisons d’utiliser le robots.txt :

- Pour interdire l’exploration des pages de mauvaise qualité.

- Pour régler des problèmes d’exploration de page.

- Pour interdire l’exploration de pages supprimées telles que les pages 410

Interdire l'indexation

En permettant de donner des consignes et des règles aux différents robots des moteurs de recherche, le fichier robots.txt permet d’éviter d’indexer certaines pages sur internet.

Particulièrement intéressant pour vos pages mentions légales, ou bien des pages qui ne sont pas censées être retrouvées sur le web.

Cela permet d’économiser des ressources à Google de ne pas explorer votre page. Il se concentrera vers vos pages qui performent le plus.

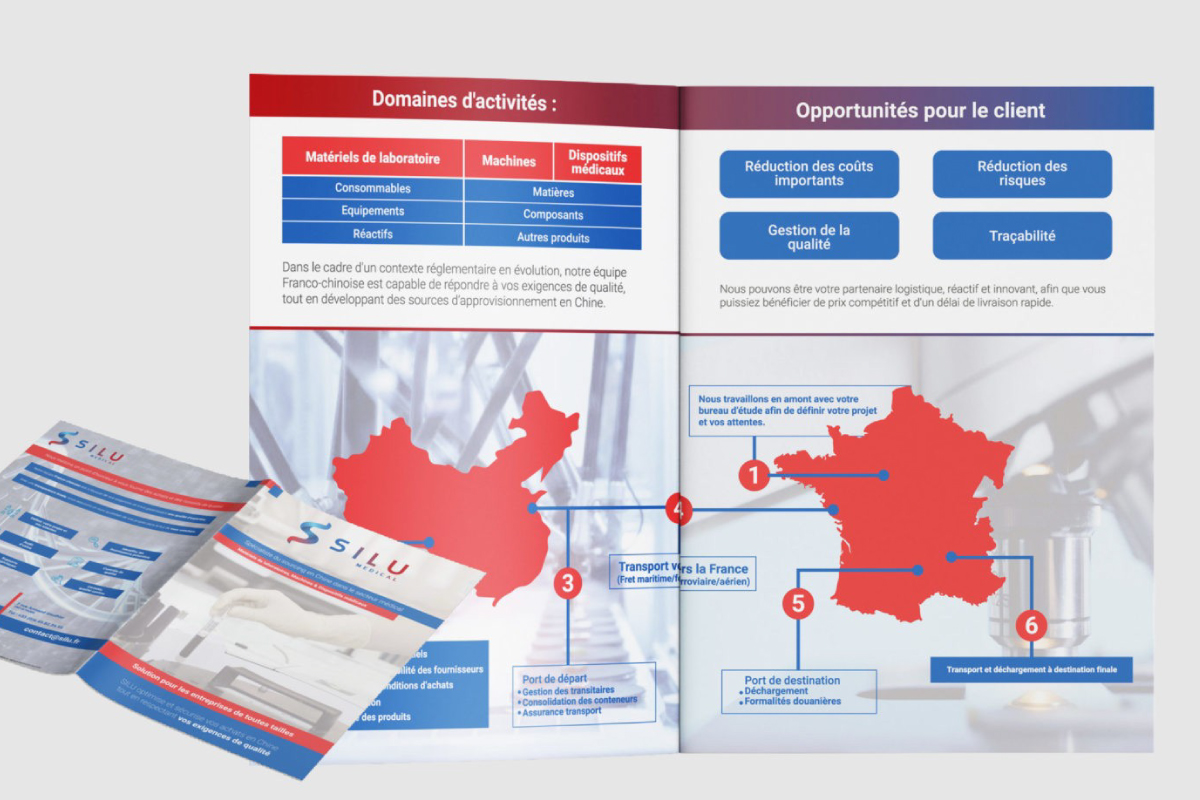

Informer l'emplacement d'un Sitemap

Le robots.txt permet d’indiquer le chemin vers un ou un sitemap. Ainsi, les moteurs de recherche découvriront plus facilement vos URL(s).

Sachez qu’un plan de site n’est pas obligatoire pour être référencé, mais il est conseillé pour une plus rapide découverte de vos nouvelles pages.

Permettre d'économiser du budget de crawl

Il permet d’économiser un budget de crawl en évitant d’explorer des pages inutiles, et donc, se concentrer uniquement vers vos pages qualitatives. Ainsi, la note de votre site perçue par Google n’en sera que meilleure !

Comment accéder au fichier robots.txt ?

Il y a plusieurs méthodes pour avoir accès à votre fichier robots.txt, mais la plus commune reste de se connecter directement sur votre serveur.

Un logiciel tel que Filezilla Server permet de se connecter à votre site internet en mode FTP.

Ainsi, vous pourrez accéder à la racine de votre site, et télécharger votre fichier actuel.

Comment modifier le robots.txt ?

Le fichier robots.txt se trouve à la racine de votre site internet. Pour vérifier qu’il est bien dans ce dossier, rendez-vous sur l’URL : http://www.site.com/robots.txt. Ce fichier est visible sur la plupart des sites, il vous suffit d’y accéder pour voir votre robots.txt.

Ajouter du code

- Le user-agent : C’est le nom du robot. Par exemple, vous pourriez configurer votre référencement différemment entre Bing et Google. Cela permet de bloquer certaines pages à certains moteurs de recherche.

- Disallow : C’est l’interdiction de crawl. En écrivant Disallow, suivi du chemin de l’URL à ne pas indexer, vous bloquez les moteurs de recherche et ils ne pourront pas crawler ces pages. Sachez que Disallow fonctionne également avec l’arborescence d’un site (pratique lorsque l’on a la même structure, et que l’on souhaite désactiver le crawl de toute la structure)

- Allow : Enfin, cet attribut permet d’autoriser une URL ou une arborescence à être crawlé (Pratique dans le cas d’une exception vis à vis de Disallow)

- Sitemap : Spécifiez simplement ici l’adresse du ou des plan(s) de votre site

Mise en pratique

- Pour indiquer l’adresse du sitemap sur votre fichier Robots.txt ( recommandé par Google ), il faut le spécifier comme ceci :

Sitemap: http://www.example.com/sitemap.xml - Si vous détenez un site internet, et que le contenu des pages www.site.fr/mauvaise-qualites/ freine votre référencement, alors, vous devriez sans doute les désactiver. Pour cela, je vous propose de lire cet exemple concret :

User-agent: Googlebot

Disallow: /mauvaise-qualites/ - En indiquant ces lignes de code, vous interdirez le Crawl de votre page à Google. Vous pouvez bien entendu vous servir de l’étoile ( * ) afin de cibler tous les moteurs de recherche.

User-agent: *

Disallow: /mauvaise-qualites/ - Si une page dans cette arborescence fait exception et que vous souhaiteriez la voir apparaitre sur Google, alors, suivez cet exemple :

User-agent: *

Disallow: /mauvaise-qualites/

Allow : /mauvaise-qualites/exception/